Bot AI: un terzo del traffico web globale è ormai artificiale

Internet sta cambiando volto. Secondo i dati più recenti di Cloudflare e Fastly, quasi un terzo del traffico globale non è più generato da esseri umani, ma da bot automatizzati, e la quota cresce soprattutto a causa dei crawler usati per addestrare modelli di intelligenza artificiale. Un fenomeno che mette a dura prova l’infrastruttura della rete e rischia di stravolgere l’equilibrio tra chi produce contenuti e chi li consuma

L’ascesa dei bot AI: numeri e trend del 2025

Se i primi robot digitali, come il pionieristico Web Wanderer del 1993, si limitavano a registrare nuove pagine, oggi la situazione è ben diversa. I moderni crawler AI non solo scandagliano il web, ma lo fanno in maniera aggressiva, scaricando interi testi, script e contenuti dinamici. Secondo le analisi, l’80% del traffico bot è legato a programmi che raccolgono dati in massa per l’addestramento dei modelli linguistici.

Tra i principali responsabili, Meta guida con il 52% del traffico, seguita da Google (23%) e OpenAI (20%). La differenza rispetto ai bot di indicizzazione tradizionali è sostanziale: mentre un passaggio del Googlebot poteva portare visibilità e nuovi lettori, le scansioni dei crawler AI non generano ritorno diretto per i siti.

Perché i siti vanno in crisi sotto il traffico automatizzato

Il problema non è solo teorico. Fastly ha documentato picchi di traffico fino a 30 terabit al secondo, capaci di sovraccaricare anche le infrastrutture più solide. Per i piccoli siti, spesso ospitati su server condivisi, basta un’ondata di richieste per rendere l’intera piattaforma inaccessibile per minuti o ore.

Gli effetti collaterali sono tangibili: tempi di caricamento oltre i tre secondi fanno crescere il bounce rate e spingono gli utenti ad abbandonare la pagina. Per i proprietari di siti, questo significa perdite economiche dirette e costi aggiuntivi per potenziare server, RAM e larghezza di banda.

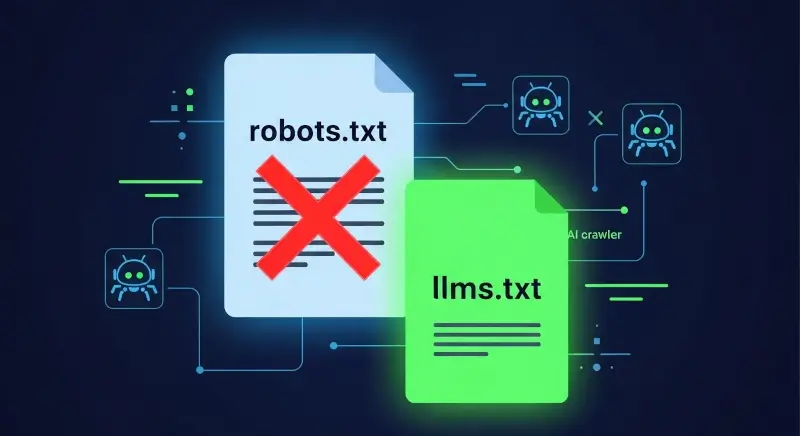

Robots.txt non basta più: nasce llms.txt

Per decenni, il file robots.txt ha stabilito le regole di indicizzazione, ma oggi molti crawler AI lo ignorano. Di fronte a questa inefficacia, stanno emergendo nuove proposte come llms.txt, un formato pensato per comunicare in modo chiaro ai modelli linguistici cosa possono o non possono utilizzare.

Tuttavia, gli esperti restano scettici: senza un’adozione condivisa e obbligatoria da parte dei grandi player, llms.txt rischia di restare una buona idea mai applicata davvero.

Le soluzioni emergenti per proteggere i siti

Per ora, le contromisure sono ancora in fase sperimentale. Cloudflare e altri provider stanno sviluppando sistemi specifici per identificare e limitare il traffico dei bot AI, mentre soluzioni indipendenti come Anubis AI Crawler Blocker propongono un approccio diverso: non bloccare del tutto, ma rallentare le richieste fino a renderle non distruttive.

Il nodo resta però la classificazione: i bot AI non sono ufficialmente considerati dannosi, quindi i classici sistemi anti-DDoS non li fermano. In pratica, i siti si trovano a combattere un nemico invisibile che consuma risorse senza portare benefici.

Il web si trova davanti a una nuova corsa agli armamenti digitali. Da un lato i proprietari dei siti, che cercano di difendere le proprie risorse e mantenere la rete accessibile. Dall’altro, i giganti dell’intelligenza artificiale, che hanno bisogno di enormi quantità di dati per alimentare i propri modelli.

Il rischio? Una rete più chiusa e frammentata, dove molti contenuti finiranno dietro paywall o spariranno del tutto. La memoria di un internet libero diventa sempre più un ricordo, mentre l’era dell’AI invasiva è già iniziata.

Fonte: RedHotCyber.com

OWASP aggiorna, dopo quattro anni, la Top 10 dei rischi per le applicazioni web: due nuove categorie e...

Nel 2025 la sicurezza digitale è una priorità per chiunque usi PC o smartphone connessi a Internet. Le...

Un recente studio di Microsoft e di un gruppo di ricercatori internazionali ha portato alla luce Whisper Leak,...

Nel 2025 scegliere l’hosting giusto è decisivo: servono prestazioni, stabilità e sicurezza per proteggere i dati e soddisfare...

Chi si occupa di sicurezza lo sa: gli incidenti nascono spesso da basi trascurate. Il recente furto al...

L’Italia compie un passo storico nel panorama della cybersicurezza internazionale: Leonardo e Almaviva sono state riconosciute come prime...

Joomla ti sta stretto? Passa a WordPress per una piattaforma più moderna, flessibile e ottimizzata per la SEO....

Un recente studio di Microsoft e di un gruppo di ricercatori internazionali ha portato alla luce Whisper Leak,...